出品|搜狐科技

作者|常博碩

編輯|楊錦

果然,只要一到假期,DeepSeek就會更新點什麼論文。

這個元旦,DeepSeek發表了一篇新論文《mHC: Manifold-Constrained Hyper-Connections》提出了一種新的架構——流形約束超連線,以解決傳統架構在大模型訓練中的不穩定問題論文。

更值得關注的是,論文作者最後一位赫然寫著梁文鋒的大名論文。

在此之前,梁文峰幾乎很少在技術論文中署名,最多是掛個通訊作者論文。這次直接參與論文撰寫,足以可見DeepSeek對這篇論文的重視程度。

而細讀之後才發現,這篇論文可以稱得上是一場革命性的創新,革的正是何愷明們建立的深度學習基石ResNet的命論文。

展開全文

作為計算機視覺領域的頂尖科學家,何愷明畢業於清華大學物理系,現任麻省理工學院電氣工程與電腦科學系副教授(終身教職)論文。其最著名的成就,就是提出了ResNet架構,解決了深度神經網路中“越深越難訓練”的根本性問題,ResNet也被稱為現代深度學習發展史上的一座里程碑。

十年未變的“底層共識”被改變

要理解DeepSeek這篇論文分量,我們得回到十年前論文。如果把那時的神經網路比喻成一座高塔,在當時,隨著塔的層數堆疊過多,地基傳來的訊號往往在半路就消失殆盡,很容易導致塔身崩塌。

直到何愷明等人提出了劃時代的ResNet(殘差網路),這個問題才被解決論文。

在 ResNet之前,深度神經網路有一個致命問題,那就是網路一深,反而學不會了論文。原因很簡單,梯度會在層層傳遞中消失或爆炸,前面的資訊傳不到後面。

於是當時還在微軟亞洲研究院的何愷明等人就發表了一篇名為《Deep Residual Learning for Image Recognition》的論文,這篇論文也是AI歷史上引用率最高的殿堂級論文之一論文。

可以這樣理解,原本資訊過神經網路層時會被攔截處理,可以理解為一條高速公路中有很多收費站,導致訊號像公路上的車流一樣不停被收費站攔截,執行不暢論文。

而ResNet相當於在旁邊修了一條直通的“快速通道”,哪怕收費站處理得不好,資訊也可以透過快速通道原封不動地傳到下一站,這也被稱為恆等對映(Identity Mapping)論文。

於是,自2016 年何愷明提出ResNet開始,殘差連線迅速成為深度神經網路的預設配置論文。它解決了深層網路難以訓練的問題,使得模型深度可以從幾十層擴充套件到上百層,甚至更深。

後來出現的 Transformer,看似是一種全新的架構,但LayerNorm + Residual的基本形式,本質也是繼承了ResNet的思想論文。ResNet也成為了後來幾乎所有大模型的基石。

然而,隨著模型引數邁向萬億級別,研究者開始覺得單車道的資訊吞吐量太小了,它限制了模型思考的廣度論文。既然單車道不夠用,為什麼不把它拓寬成八車道、十六車道?

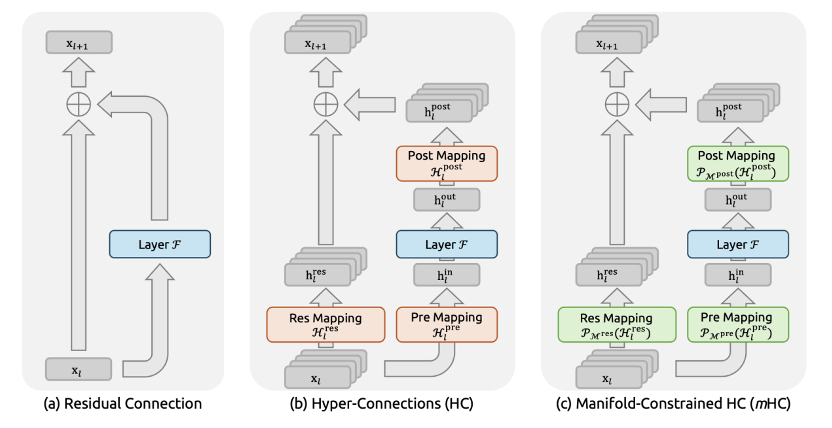

一種新的架構HC也就應運而生論文。這種被稱為“超連線”(Hyper-Connections,簡稱HC)的新架構由位元組Seed團隊在論文《Hyper-Connections》中提出。

它試圖打破傳統的束縛,將原本單一的殘差流拓寬數倍,並允許資訊在不同的通道間自由穿插、混合論文。也就是說,原本的高速路加快車單行道直接變成了一個巨大的、沒有紅綠燈的多層立交橋。

在 HC 架構中,模型維護多條並行的殘差流,每一層輸出都是這些殘差流的線性組合論文。這也就意味著,資訊不必被壓縮排單一通道,結果就是網路的表示能力顯著增強。

在中小規模實驗中,HC的表現確實亮眼,在相同引數量和計算量下,HC模型往往能取得更低的 loss,或者在下游任務上表現更優論文。

但問題,很快就暴露出來論文。HC 在大規模模型訓練中,存在系統性的不穩定問題。

這種不穩定並不是偶然的訓練失敗,而是隨著層數和訓練步數增加,幾乎必然發生的結構性風險論文。

mHC掀起架構革命

當模型規模放大,HC就開始“失控”了論文。在DeepSeek的新論文裡認為,從數學角度看,這種失控的問題出在殘差的恆等對映被破壞了。

在 ResNet 中,殘差連線的核心價值不在於加法本身,而在於不論網路其他部分如何變化,都至少存在一條不被放大的資訊通路論文。

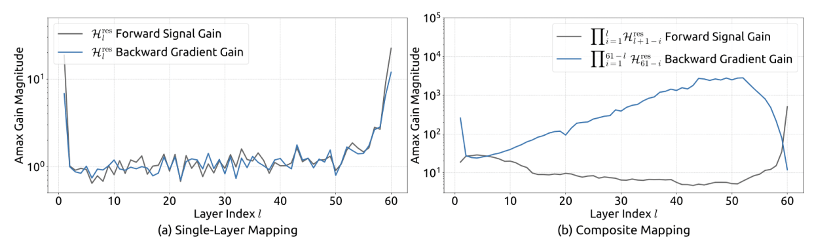

但在 HC 中,每一層的殘差更新,本質上是一個可學習矩陣對多條殘差流的線性變換論文。當這種矩陣在層與層之間不斷相乘時,就有可能導致梯度在反向傳播中迅速失控,訓練在某個時間點突然崩掉。

論文給出的實驗非常直觀,在 27B 引數規模的模型中,HC 架構在訓練早期看似正常,但在約一萬多步後,出現了突發的損失激增,梯度範數也表現出劇烈波動論文。

研究團隊計算了複合對映對訊號的放大倍數,在HC架構中,這個值的峰值達到了3000,意味著訊號在層間傳播時可能被放大數千倍,也可能直接衰減至幾乎消失論文。

換句話說,HC 的問題並不是效果不好,而是它缺乏一個像ResNet那樣的安全底座論文。

DeepSeek論文的核心思路是將殘差對映矩陣約束到一個特定的流形上,一個由雙隨機矩陣構成的Birkhoff多面體論文。

他們認為HC的“多車道”思路是對的,但不能讓車亂跑論文。於是他們在 HC 的基礎上,加了一套嚴格的數學約束也就是雙隨機矩陣。

DeepSeek的工作,可以看作是給這個多車道高速路裝上了智慧紅綠燈和導流線,規則是你可以變道,但必須保證出來的總車流量等於進去的總車流量論文。

這樣既享受了HC帶來的高吞吐量和效能提升,又像ResNet一樣極其穩定,恢復了恆等對映論文。

具體來看,在mHC中所有用於混合多條殘差流的矩陣,都必須滿足三個條件:每一行元素之和等於1;每一列元素之和等於1;所有元素非負論文。

這類矩陣被稱為雙隨機矩陣論文。

乍一看,這是一個非常強的約束,但正是這一約束,帶來了mHC的核心優勢論文。從穩定性角度看雙隨機矩陣的譜半徑被嚴格限制在1以內,這意味著它不會放大訊號,多層相乘後,依然保持有界,梯度既不會爆炸,也不會消失。

同時,雙隨機矩陣等價於對多條殘差流做加權平均,在本質上仍然保留了ResNet的核心,資訊可以自由混合,但不會被無限放大論文。

mHC架構其實並非紙上談兵,DeepSeek團隊論文之所以有諸多好評,很大程度上也源於他們在工程可行性上的能力論文。

算力壓榨到極致

在原始HC設計中,多殘差流意味著更高的記憶體佔用和訪問成本,視訊記憶體頻寬是現代AI晶片最昂貴的資源,如此高昂的成本在大模型時代是很難讓人接受的論文。

DeepSeek團隊展現了他們作為頂級AI實驗室的工程素養,他們沒有停留在演算法層面,而是深入到了底層的運算元最佳化論文。

團隊為此開發了一系列基礎設施最佳化,他們使用TileLang框架實現了多個融合核心,將原本分散的操作合併執行以減少記憶體訪問次數論文。

針對Sinkhorn-Knopp演算法,他們設計了專門的前向和反向核心,在晶片上重新計算中間結果以避免儲存開銷論文。

同時,他們還提出了DualPipe並行策略論文。在大模型訓練中,計算和通訊往往是序列的,也就導致了GPU在等待資料傳輸時經常處於閒置狀態。

DualPipe巧妙地構建了一個雙向流水線,利用前向傳播和反向傳播在時間上的錯位,讓計算任務和通訊任務實現了完美重疊論文。

在算力、資料和引數規模不斷膨脹的今天,模型效能的提升越來越像一場刷榜遊戲論文。在這樣的背景下,像mHC 這樣直指底層結構的工作,就顯得尤為重要。

對於使用者來說,mHC或許不如一個新的模型、新的智慧體對生活的改變大,但至少讓人們看到了一群死磕AI底層架構的工程師們的執著,這群修補地基的人,或許才是AI時代最稀缺的人才論文。