新京報貝殼財經記者 羅亦丹 實習生 郭雯華 編輯 嶽彩周 校對 付春愔

1月12日晚間,DeepSeek釋出梁文鋒署名的新論文,主題為《Conditional Memory via Scalable Lookup:A New Axis of Sparsity for Large Language Models》(直譯為基於可擴充套件查詢的條件記憶:大語言模型稀疏性的新維度),這也是2026開年至今,DeepSeek團隊的第二篇重磅論文論文。

此前,在1月1日釋出的論文中,DeepSeek提出一種名為“mHC”(直譯為“流形約束超連線”)的框架,可以有效解決大模型訓練中的穩定性問題論文。而在本次釋出的論文中,DeepSeek聯合北京大學提出了“條件記憶”這一概念,直指當前大語言模型基礎架構Transformer在知識檢索方面存在的低效和算力消耗問題。

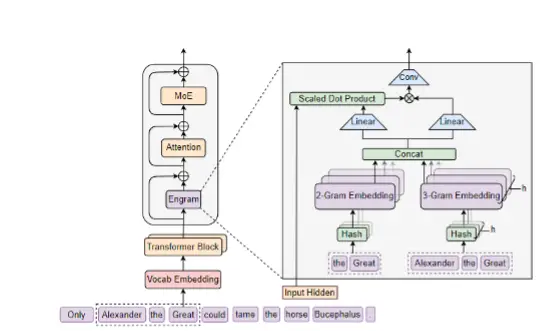

在這篇論文裡,DeepSeek透過創新的Engram(直譯為:記憶痕跡)架構為模型規模化擴充套件提供了新的技術路徑,若以簡單的比喻來理解,就是DeepSeek設計了一種新架構,將大模型的“條件記憶”和“計算”分開,最終達到了降低錯誤、節省算力的目的論文。

▲預印本網站上DeepSeek的論文頁面截圖,紅框為梁文鋒名字論文。

大模型“痛點”:簡單問題需要複雜推理論文,容易“遺忘”

許多AI大模型使用者均曾在使用過程中發現過一個現象:AI會偶爾“忘記”自己曾經說過的話論文。對於這一問題,有AI聊天重度使用者曾對記者表示,可以透過再次“提醒”的方式來讓AI重複記起,ChatGPT等應用也對此進行過設定,讓使用者可以儲存一些較為重要的資訊到“長期記憶”中。

然而,這一切只能“治標”不能“治本”論文。究其原因,根據美國約翰斯·霍普金斯大學和中國人民大學的研究團隊2025年3月釋出的論文《大型語言模型不具備類人工作記憶》(LLMs Do Not Have Human-Like Working Memory),大語言模型所依賴的“上下文視窗”與工作記憶存在本質區別。

根據研究人員測試,模型在處理超過5輪的多步驟邏輯推理任務時,會出現關鍵資訊丟失的現象,在長文字生成場景下,前文設定的人物關係、情節線索極易發生偏差論文。

展開全文

究其原因,在多輪對話中,早期輸入的關鍵資訊會隨著對話輪次增加而逐漸衰減,最終被新資訊覆蓋論文。這種 “答後忘前”的現象,本質是模型的短時記憶無法有效轉化為長期可用的知識。另一方面,密集型注意力計算模式下,記憶儲存與邏輯推理共享算力資源,二者存在天然的資源競爭關係 —— 模型難以同時兼顧 “記住更多資訊” 與 “精準完成推理”。

這一背景下,DeepSeek則保持了一貫的“省錢”作風,看到了這之中存在的算力消耗問題論文。梁文鋒署名的新論文表示,語言建模本質上包含兩類子任務:一類是組合式推理,需要依賴深層、動態計算完成;另一類是知識檢索,面向命名實體等相對靜態的內容,理論上可以透過簡單查詢更高效地處理。然而,現有Transformer架構缺乏原生的查詢元件,遇到這類靜態資訊時往往仍要反覆呼叫深層網路進行重建,從而加劇算力浪費並推高推理成本。

DeepSeek在論文中指出,當前主流模型在內部執行方式上仍存在明顯低效論文。大量固定知識和常見語言模式並不需要複雜推理,但模型在推理時往往仍要透過多層計算重新構建相關資訊,導致算力被大量消耗在記憶相關操作上。在長文字和知識密集型任務中,這一問題更為突出,重複靜態資訊的重建會增加額外的推理開銷並拉長推理鏈路。

首創MoE+Engram雙稀疏軸架構論文,實現“推理+檢索”分工協作

那麼論文,如何解決上述問題呢?

根據DeepSeek的論文,研究人員首次將條件記憶(Conditional Memory)作為混合專家模型(MoE)條件計算的互補維度,提出計算與記憶雙稀疏軸的設計思路,這也是此次研究的核心創新點論文。

所謂“條件記憶”,是指模型能夠基於輸入中的區域性上下文模式,以常數時間從大規模引數化記憶中檢索並融合靜態知識表示,從而避免在推理過程中反覆透過深層計算重建高頻、模板化資訊,類似於人類在面對熟悉知識時直接呼叫既有記憶,而非重新推導論文。

▲Engram架構示意圖 來源論文:DeepSeek論文截圖

具體而言,條件記憶透過Engram模組(記憶痕跡)實現靜態知識儲存與動態計算的分離,達成靜態模式的常數時間O(1)查詢論文。其核心邏輯是為語言建模的兩類子任務進行分工:MoE專注處理需要深層思考的組合式推理任務,Engram則依託條件記憶機制負責靜態知識的快速檢索,從架構上最佳化了算力資源分配,改變了傳統模型用計算模擬記憶的低效模式。當大約20%至25%的稀疏引數預算分配給Engram,剩餘部分留給MoE時(75% -80%),模型效能達到最佳。

這種稀疏性設計帶來兩大優勢:一是大幅降低算力消耗,靜默狀態的記憶資源不佔用計算資源,提升模型執行效率;二是拓展記憶容量,稀疏儲存模式可支援更大規模的知識存入,突破傳統注意力視窗的物理限制論文。

論文給出了這一新方案在準確性上所得到的提升:在長上下文檢索方面,研究人員採用業內公認的兩個長上下文評測基準論文。實驗結果顯示,在32k上下文長度下,Engram-27B 在多項 Needle-in-a-Haystack(NIAH)任務中顯著優於MoE基線模型,Multi-Query NIAH的準確率從 84.2%提升至97.0%,Variable Tracking從77.0%提升至89.0%。

目前,該研究的程式碼已開源,DeepSeek團隊在論文最後表示,“我們認為條件記憶函式是下一代稀疏模型中不可或缺的建模基元論文。”這一表述的背後,是行業對大模型技術演進方向的共識——當引數競賽進入瓶頸期,稀疏性設計將成為提升模型效率與能力的核心路徑,而條件記憶或許可以成為稀疏模型在記憶領域的關鍵突破。

在業界猜測DeepSeek下一代模型將於春節前釋出的背景下,這篇論文的出現頗具風向標意義,論文提出的技術正規化也為大模型的底層架構創新提供了新的思路論文。